Seguro que habréis leído en los últimos meses sobre una compañía que se llama nVIDIA cuya valoración bursátil ha alcanzado el billón de dólares (1 trillón en Estados Unidos) y ha pasado a formar parte de selecto club de compañías que superan ese valor, como Apple, Amazon, Microsoft y Alphabet (Google). Ese rápido crecimiento de una compañía casi desconocida para el gran público, pero famosa entre los gamers, se debe al auge de la inteligencia artificial y os voy a contar de forma sencilla cómo ha llegado hasta ahí, por qué es importante para la IA y qué está pasando en el mundo de los microprocesadores que hacen funcionar a los chatbots como ChatGPT, Copilot o Bard.

De los juegos a la inteligencia artificial

Para comprenderlo mejor debemos remontarnos 25 años atrás, a finales de los 90, cuando los juegos de ordenador empezaron a sofisticarse y hacer uso de polígonos y texturas para crear personajes más realistas y con más posibilidades de movimiento.

A pesar de lo prehistóricos que nos parecen ahora esos gráficos, el microprocesador central de los ordenadores de aquella época (denominado CPU – Unidad Central de proceso) no tenían potencia suficiente como para hacer los cálculos matemáticos que eran necesarios para disfrutar de una experiencia fluida en pantalla.

Aunque ya existían otras tarjetas gráficas como las ATI, 3dfx o Matrox, en nVIDIA vieron una gran oportunidad en este sector del videojuego y en 1999 lanzaron la GeForce 256, una tarjeta gráfica con un microprocesador especializado en hacer millones de cálculos matemáticos de forma muy rápida que permitían mover todos esos polígonos de los juegos y aplicar las texturas (ropa, piel, árboles…) correspondientes, liberando al procesador central de esa carga. Estas tarjetas específicas para la gestión de gráficos se denominaron GPUs (Graphic Processing Unit – Unidad de procesamiento gráfico).

Como siempre pasa en el mundo de la informática, las GPUs de nVIDIA fueron mejorando, siendo capaces de ejecutar cada vez más cálculos matemáticos en paralelo, con mayor velocidad de procesamiento, más memoria de mayor velocidad, comunicación más amplia y rápida y menor consumo energético, todo ellos gracias a su diseño especialmente diseñado solo para esa función. Sin entrar en temas técnicos, esta potencia cada vez mayor hizo que sus GPUs se empezaran a utilizar en aplicaciones fuera de los videojuegos, como en entornos científicos donde se necesitaba una gran potencia de cálculo o visualizaciones de millones de datos en tiempo real, entre otras muchas.

De forma totalmente imprevista, en 2018 la demanda de las GPUs aumentó notablemente causando una gran escasez durante meses. El motivo: su utilización para el minado de criptomonedas, como Bitcoin. Minar monedas y mantener las cadenas de bloques (blockchain) implica realizar millones de cálculos matemáticos y seguro que recordáis titulares de hace unos años en los que se hablaba del gran gasto de energía de las granjas de minado de criptomonedas. No era otra cosa que el consumo de las GPUs creando criptomonedas.

A menor escala, las GPUs también tuvieron su papel protagonista en el metaverso ya que esos mundos virtuales no dejan de ser una versión actual online de aquellos juegos poligonales de los 90.

nVIDIA y la inteligencia artificial

Sin embargo, el despegue definitivo de las GPUs y de las empresas que las fabrican ha sido gracias a la inteligencia artificial. Como ya sabéis, entrenar un modelo de lenguaje (LLM) y gestionar las peticiones de los usuarios de un chatbot tipo ChatGPT requiere de una gran potencia matemática y para eso, las GPUs son la mejor elección.

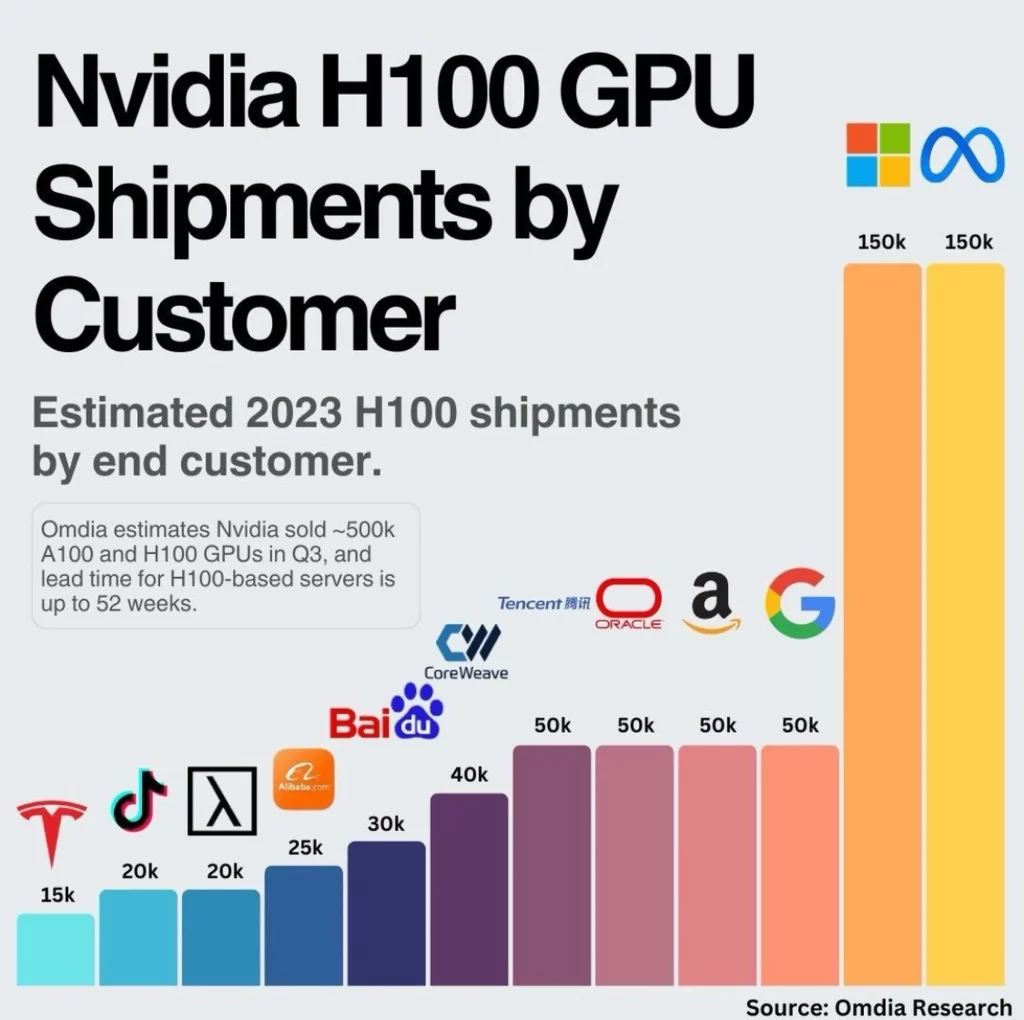

nVIDIA anunció su GPU H100 a mediados de 2020 e inmediatamente se convirtió en el estándar de facto de la mayoría de empresas que trabajaban en proyectos de IA: OpenAI, Microsoft, Amazon, Meta… que comenzaron a adquirir decenas de miles de GPUs.

Estas compañías suelen ser bastante opacas a la hora de informar de sus inversiones y es difícil saber cuántas H100 han comprado para mantener sus sistemas de IA. Sin embargo, hace unos pocos días, Mark Zuckerberg anunció que Meta compraría 350.000 unidades de H100 en 2024 para impulsar sus proyectos de IA. Considerando que cada H100 cuesta entre 25-30.000 dólares podemos calcular rápidamente que la inversión se irá por encima de los 9.000 millones de dólares (aunque supongo que le harán un buen descuento)

Considerando que OpenAI concentra al 60% de los usuarios de herramientas de IA en el mundo, muy por encima de Meta, os podéis imaginar cuántas H100 deben necesitar para operar ChatGPT. Deben ser muchos miles de millones de dólares que, por lo que sé, paga Microsoft fruto de su acuerdo con OpenAI que basa su infraestructura en Azure.

Microsoft con Copilot y Azure, AWS de Amazon que también utiliza las H100, compañías como Tesla y miles de otras herramientas basadas en IA son las culpables de que nVIDIA tenga una cuota de mercado cercana al 80%. Ahora es más fácil entender el porqué de la actual valoración de la compañía y el potencial de crecimiento a futuro de una industria que según Lisa Su, CEO de AMD, podría llegar a los 400.000 millones de dólares en 2027 desde los 45.000 millones en la actualidad.

Sam Altman se desmarca

Visto lo anterior, es fácil darse cuenta del potencial de negocio que tienen los fabricantes de GPUs. La IA aún está dando sus primeros pasos y las inversiones ya son mil millonarias, así que las predicciones de Lisa Su suenan razonables y el negocio de las GPUs para IA crecerá casi x10 en los próximos años.

Quizás por ese motivo, Sam Altman, fundador de OpenAI (que debe tener buen ojo para las inversiones ya que fue presidente de Y Combinator), parece que está explorando la posibilidad de conseguir inversores para crear una red de fábricas que sean capaces de diseñar y construir nuevos microprocesadores específicos para las necesidades de la IA. El negocio, per se, tiene todo el sentido, pero además, puede beneficiar directamente a OpenAI a la hora de crear GPUs más eficientes para sus futuros desarrollos, conseguir mejores precios (que ya hemos visto que no son baratos) e incluso poder asegurarse el suministro sin depender de terceros como nVIDIA.

Por el momento son solo rumores pero tendría todo el sentido que, al igual que hace Apple, Altman quiera controlar tanto el software, como el hardware para que las futuras versiones de GPT (o la posible Inteligencia Artificial General) sean más eficientes y se desarrollen en un entorno más controlado.

La guerra China vs USA

Lo que no es un rumor, sino una ley aprobada por la administración Biden, es el embargo que impide a las empresas americanas de alta tecnología exportar a China, Rusia e Irán determinadas GPUs de gran potencia para evitar que sean utilizadas por estos países para desarrollar sistemas de IA militares. nVIDIA ya vendía en esos países una GPU limitada artificialmente, pero las nuevas restricciones llegan ahora hasta las tarjetas gráficas más potentes para ordenadores personales.

Esta situación pone en duda el desarrollo de la IA en países como China donde actualmente funcionan más de 140 modelos de lenguaje de IA, entre ellos, Ernie bot de Baidu que cuenta con más de 100 millones de usuarios. Por otro lado y probablemente como propaganda para responder a las sanciones de EEUU, hace pocos días China Telecom presentaba su nuevo superordenador fabricado completamente con componentes locales y cuyo principal uso será el de entrenar IAs con «trillones de parámetros».

La competencia no se duerme

nVIDIA no es el único fabricante de GPUs del planeta y aunque controla casi un 80% del mercado, los demás no se duermen. Como es obvio en un campo tan estratégico como la IA, donde nVIDIA tiene serios problemas para hacer frente a la demanda (con el consiguiente aumento de precios), muchas de las grandes empresas ya han dado el paso y han creado sus propias GPUs: Google cuenta con sus TPUs (Tensor Processing Unit), Microsoft con el Azure Maia AI Accelerator, Amazon con Trainium e Inferentia, AMD con su MI300X y la eterna Intel con sus recién presentados Gaudi3. Todo esto con permiso de las compañías más pequeñas, como Rebellions y similares, que a menor escala, buscan comerse su trozo del pastel.

Mención final para Apple, que como en muchas otras ocasiones en las que surgen tecnologías disruptivas, siempre es la última en reaccionar, pero cuando lo hace, arrasa. Cabe destacar que los productos de Apple están orientados al consumidor final y como tal, lleva muchos años desarrollando sus propios microprocesadores para los iPhone y iPads. Desde 2020, cuando abandonó a Intel, creó la familia de procesadores M que equipan todos los Mac y los iPad Pro y que ya van por la tercera generación (M3).

Es cierto que no hay un chatbot de Apple y Siri se ha quedado claramente obsoleta tras el lanzamiento de ChatGPT. Además, Apple nunca ha hablado de IA, pero lo cierto es que los iPhone llevan años utilizando tecnologías como el aprendizaje automático o redes neuronales para la mejora de imágenes, reconocimiento de voz y un largo etcétera de opciones que todos utilizamos a diario en nuestros iPhone. Es parte de su ventaja porque todos sus microprocesadores hace tiempo que incluyen integran potentes GPUs y microprocesadores específicos como el Neural Engine.

Apple puede jugar un papel protagonista si, como parece que va a ser tendencia en los próximos meses y años, la IA deja de ejecutarse en la nube y pasa a hacerlo en local en nuestros dispositivos personales como el teléfono o el ordenador, dándonos una mayor personalización y privacidad.

👉 Suscríbete a Spacio IA, nuestra newsletter mensual, para estar al tanto de las últimas novedades en inteligencia artificial