Un gran salto en potencia y eficiencia

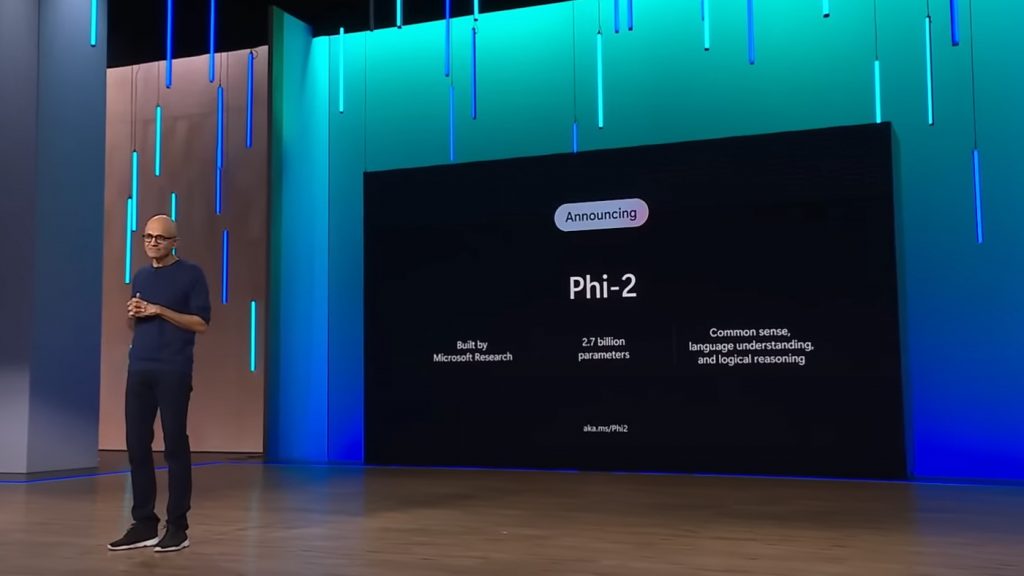

Los investigadores de Microsoft AI han desarrollado un modelo de lenguaje que iguala o supera el rendimiento de modelos mucho más grandes utilizando una fracción de sus parámetros. Parece difícil de creer, pero es exactamente lo que han logrado con Phi-2.

Con sólo 2.700 millones de parámetros, Phi-2 demuestra una capacidad asombrosa de razonamiento del lenguaje y comprensión. De hecho, supera a modelos más grandes como LLaMA y Mistral en una variedad de tareas, desde razonamiento de sentido común hasta problemas matemáticos y de codificación.

Este hito plantea preguntas importantes sobre el futuro de los modelos de lenguaje a gran escala. ¿Realmente se necesitan cientos de miles de millones de parámetros para lograr un rendimiento de primer nivel? ¿O hay enfoques más estratégicos que pueden desbloquear capacidades avanzadas de una manera más eficiente?

El enfoque innovador detrás de Phi-2

El éxito de Phi-2 se basa en el enfoque cuidadoso de su equipo de investigación a la selección de datos y las técnicas de escalado. En lugar de simplemente arrojar más datos y potencia computacional al modelo, se centraron en la calidad sobre la cantidad:

- Seleccionaron subconjuntos de Wikipedia y otros recursos que exhibían texto de «calidad de libro de texto», con oraciones claras y bien estructuradas.

- Crearon conjuntos de datos sintéticos diseñados para enseñar sentido común, razonamiento analógico y conocimiento general.

- Emplearon técnicas innovadoras de escalado del modelo para mejorar la eficiencia.

Con sólo 14 días de entrenamiento en 96 GPUs A100, Phi-2 surgió como un modelo compacto pero sorprendentemente capaz, listo para establecer nuevos estándares de lo que es posible en IA.

Implicaciones más allá de los benchmarks

La proeza de rendimiento de Phi-2 tiene ramificaciones que van más allá de las puntuaciones de referencia. Al demostrar capacidades de primer nivel con una fracción de los recursos informáticos, abre nuevas posibilidades para la investigación y la implementación práctica:

- Permite a más investigadores experimentar y iterar rápidamente con menos demanda de hardware.

- Facilita el despliegue en la nube y en el borde sin la pesada carga de los mega-modelos.

- Promete nuevos avances en áreas como dispositivos móviles y IoT donde la eficiencia es fundamental.

Y lo que es más importante, Phi-2 indica un camino a seguir centrado no solo en escalar modelos, sino en escalar su inteligencia. Un enfoque que, con el tiempo, podría conducir a IA verdaderamente versátil y de uso general al alcance de todos.

Un punto de inflexión en la investigación de la inteligencia artificial

Phi-2 representa uno de esos raros avances que redefine las fronteras de lo posible en inteligencia artificial. Al desafiar suposiciones sobre el tamaño y los recursos necesarios para lograr un rendimiento sobresaliente, marca un punto de inflexión para el campo.

Y esto es sólo el comienzo. A medida que los investigadores aprovechen y refinen las lecciones de Phi-2, esperamos ver una nueva ola de modelos que sean a la vez accesibles y capaces, eficientes y versátiles.

Modelos que finalmente pueden cumplir el sueño original de la IA: soluciones inteligentes disponibles y beneficiosas para todos. Phi-2 nos acerca un paso más hacia esa visión.

Fuente: Phi-2: The surprising power of small language models