Continuamos viendo avances en los modelos más pequeños de inteligencia artificial que tienen como objetivo funcionar directamente en los dispositivos móviles, sin necesidad de tener conexión a internet.

A mediados de diciembre de 2023, Microsoft anunciaba Phi-2. Solo han pasado 4 meses y ya tenemos entre nosotros una nueva versión del modelo de lenguaje de inteligencia artificial. Esta da una idea de la tremenda velocidad a la que evoluciona el campo de la IA.

Características técnicas

Phi-3 se encuadra en los denominados SLM (Small Language Models), es decir, modelos de lenguajes pequeños que han sido entrenados con menos parámetros que los modelos gigantes, como GPT-4, Llama 3 o Gemini. Para hacernos una idea, Meta está entrenando una versión de Llama 3 con 400.000 millones de parámetros, mientras que Phi-3 «solo» ha utilizado 3.800 millones de parámetros. Según Microsoft, la innovación proviene de los datos empleados para entrenar al modelo, que consiste en información filtrada de internet, así como de datos sintéticos (generados por otras IA).

Es curioso leer en la documentación técnica que Phil-3 ha utilizado en su entrenamiento cuentos infantiles y que, como no hay muchos, se ha pedido a otra IA que creara más cuentos para alimentar el modelo. También se ha eliminado información superflua, como resultados de partidos de la Premier League a cambio de añadir más capacidad de razonamiento. Así que este modelo no es para futboleros.

Sin embargo, esto no es problema para que, a nivel de resultados, Phi-3 esté al nivel de modelos más grandes, como Mistral 8x7B y GPT-3.5, que es la versión gratuita de ChatGPT.

Microsoft Phi-3 es en realidad una familia de diferentes modelos ya que hay varias versiones: Mini (3.8B), Small (7B) y Medium (14B)

La IA está llegando al móvil

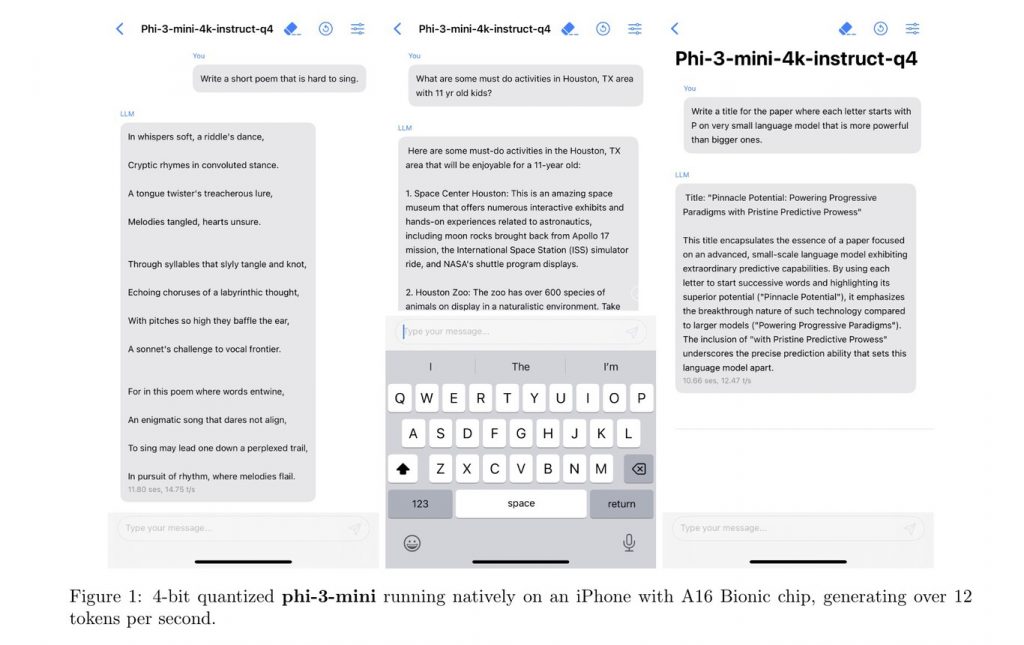

El objetivo de crear modelos tan pequeños es poder ejecutarlos de forma nativa en diferentes dispositivos, como teléfonos móviles, tablets u ordenadores personales. Los chatbots que utilizamos ahora, como ChatGPT, Gemini o Copilot, se ejecutan en la nube y necesitan una gran infraestructura de computación para atender todas las consultas que, además, consumen cantidades ingentes de energía y tienen riesgos de privacidad.

Por el contrario, modelos como Phi-3 Mini ocupan solo 1.8 Gb de memoria y Microsoft indica que lo han probado en un iPhone 14 con muy buenos resultados. El hecho de tener esa inteligencia artificial ejecutándose en tu dispositivo implica una mayor privacidad porque, en teoría, la información no sale de tu móvil o PC. Tampoco hace falta que tengas conexión a internet. Por último, todas las consultas que hagas en local se las ahorran los Google, OpenAI y similares, que gastan menos energía eléctrica. De lo que nadie esta hablando es de que tu móvil consumirá más batería porque la inferencia (hacer preguntas) a la IA requiere de mucho cálculo matemático y eso consume energía.